11 Mar 2026

Fedora People

Fedora People

Peter Czanik: The syslog-ng Insider 2026-03: 4.11.0 release; OpenSearch; ElasticSearch

11 Mar 2026 12:01pm GMT

10 Mar 2026

Fedora People

Fedora People

Fedora Magazine: How to rebase to Fedora Silverblue 44 Beta

Silverblue is an operating system for your desktop built on Fedora Linux. It's excellent for daily use, development, and container-based workflows. It offers numerous advantages such as being able to roll back in case of any problems. This article provides the steps to rebase to the newly released Fedora Linux 44 Beta, and how to revert if anything unforeseen happens.

NOTE: Before attempting an upgrade to the Fedora Linux 44 Beta, apply any pending upgrades to your current system.

Updating using the terminal

Because Fedora Linux 44 Beta is not available in GNOME Software, the whole process must be done through a terminal.

First, check if the 44 branch is available, which should be true now:

$ ostree remote refs fedora

You should see the following line in the output:

fedora:fedora/44/x86_64/silverblue

If you want to pin the current deployment (this deployment will stay as an option in GRUB until you remove it), you can do it by running:

# 0 is entry position in rpm-ostree status

$ sudo ostree admin pin 0

To remove the pinned deployment use the following command ( "2" corresponds to the entry position in the output from rpm-ostree status ):

$ sudo ostree admin pin --unpin 2

Next, rebase your system to the Fedora 44 branch.

$ rpm-ostree rebase fedora:fedora/44/x86_64/silverblue

The final thing to do is restart your computer and boot to Fedora Silverblue 44 Beta.

How to revert

If anything bad happens - for instance, if you can't boot to Fedora Silverblue 44 Beta at all - it's easy to go back. Pick the previous entry in the GRUB boot menu (you need to press ESC during boot sequence to see the GRUB menu in newer versions of Fedora Silverblue), and your system will start in its previous state. To make this change permanent, use the following command:

$ rpm-ostree rollback

That's it. Now you know how to rebase to Fedora Silverblue 44 Beta and fall back. So why not do it today?

Known issues

FAQ

Because there are similar questions in comments for each blog about rebasing to newer version of Silverblue I will try to answer them in this section.

Question: Can I skip versions during rebase of Fedora Linux? For example from Fedora Silverblue 42 to Fedora Silverblue 44?

Answer: Although it could be sometimes possible to skip versions during rebase, it is not recommended. You should always update to one version above (42->43 for example) to avoid unnecessary errors.

Question: I have rpm-fusion layered and I got errors during rebase. How should I do the rebase?

Answer: If you have rpm-fusion layered on your Silverblue installation, you should do the following before rebase:

rpm-ostree update --uninstall rpmfusion-free-release --uninstall rpmfusion-nonfree-release --install rpmfusion-free-release --install rpmfusion-nonfree-release

After doing this you can follow the guide in this article.

Question: Could this guide be used for other ostree editions (Fedora Atomic Desktops) as well like Kinoite, Sericea (Sway Atomic), Onyx (Budgie Atomic),…?

Yes, you can follow the Updating using the terminal part of this guide for every ostree edition of Fedora. Just use the corresponding branch. For example for Kinoite use fedora:fedora/44/x86_64/kinoite

10 Mar 2026 7:29pm GMT

Marcin Juszkiewicz: RISC-V is sloooow

About 3 months ago I started working with RISC-V port of Fedora Linux. Many things happened during that time.

Triaging

I went through the Fedora RISC-V tracker entries, triaged most of them (at the moment 17 entries left in NEW) and tried to handle whatever possible.

Fedora packaging

My usual way of working involves fetching sources of a Fedora package (fedpkg clone -a) and then building it (fedpkg mockbuild -r fedora-43-riscv64). After some time, I check did it built and if not then I go through build logs to find out why.

Effect? At the moment, 86 pull requests sent for Fedora packages. From heavy packages like the "llvm15" to simple ones like the "iyfct" (some simple game). At the moment most of them were merged, and most of these got built for the Fedora 43. Then we can build them as well as we follow 'f43-updates' tag on the Fedora koji.

Slowness

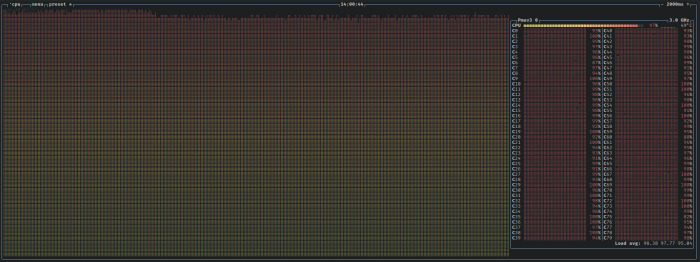

Work on packages brings the hard, sometimes controversial, topic: speed. Or rather lack of it.

You see, the RISC-V hardware at the moment is slow. Which results in terrible build times - look at details of the binutils 2.45.1-4.fc43 package I took from koji (Fedora and RISC-V Fedora):

| Architecture | Cores | Memory | Build time |

|---|---|---|---|

| aarch64 | 12 | 46 GB | 36 minutes |

| i686 | 8 | 29 GB | 25 minutes |

| ppc64le | 10 | 37 GB | 46 minutes |

| riscv64 | 8 | 16 GB | 143 minutes |

| s390x | 3 | 45 GB | 37 minutes |

| x86_64 | 8 | 29 GB | 29 minutes |

That was StarFive VisionFive 2 board, while it has other strengths (such as upstreamed drivers), it is not the fastest available one. I asked around and one of porters did a built on Milk-V Megrez - it took 58 minutes.

Also worth mentioning is that the current build of RISC-V Fedora port is done with disabled LTO. To cut on memory usage and build times.

RISC-V builders have four or eight cores with 8, 16 or 32 GB of RAM (depending on a board). And those cores are usually compared to Arm Cortex-A55 ones. The lowest cpu cores in today's Arm chips.

The UltraRISC UR-DP1000 SoC, present on the Milk-V Titan motherboard should improve situation a bit (and can have 64 GB ram). Similar with SpacemiT K3-based systems (but only 32 GB ram). Both will be an improvement, but not the final solution.

Hardware needs for Fedora inclusion

We need hardware capable of building above "binutils" package below one hour. With LTO enabled system-wide etc. to be on par with the other architectures. This is the speed-related requirement.

There is no point of going for inclusion with slow builders as this will make package maintainers complain. You see, in Fedora build results are released into repositories only when all architectures finish. And we had maintainers complaining about lack of speed of AArch64 builders in the past. Some developers may start excluding RISC-V architecture from their packages to not have to wait.

And any future builders need to be rackable and manageable like any other boring server (put in a rack, connect cables, install, do not touch any more). Because no one will go into a data centre to manually reboot an SBC-based builder.

Without systems fulfilling both requirements, we can not even plan for the RISC-V 64-bit architecture to became one of official, primary architectures in Fedora Linux.

I still use QEMU for local testing

Such long build times make my use of QEMU useful. My AArch64 desktop has 80 cores, so with the use of QEMU userspace riscv64 emulation, I can build the "llvm15" package in about 4 hours. Compare that to 10.5 hours on a Banana Pi BPI-F3 builder (it may be quicker on a P550 one).

And LLVM packages make real use of both available cores and memory. I am wondering how fast would it go on 192/384 cores of Ampere One-based system.

Still, I used QEMU for local builds/testing only. Fedora, like several other distributions, does native builds only.

Future plans

We plan to start building Fedora Linux 44. If things go well, we will use the same kernel image on all of our builders (the current ones use a mix of kernel versions). LTO will still be disabled.

When it comes to lack of speed… There are plans to bring new, faster builders. And probably assign some heavier packages to them.

10 Mar 2026 5:53pm GMT

Tim Waugh: Searching Logseq by Concept, Not Keystrokes

Logseq is great for dumping daily notes, but finding them again later can be a pain. If you're looking for notes on a "connection timeout" but originally wrote "increasing the socket keepalive", a standard keyword search will give you nothing. You end up having to guess the exact phrasing your past self used.

I wanted a way to search my graph by concept rather than exact text matches. That's why I put together the Logseq Semantic Search plugin.

The upcoming database version of Logseq actually has semantic search built-in. But since I'm still using the standard Markdown version for my day-to-day workflow, I wanted to get that capability right now.

Indexing the hierarchy

The plugin uses text embeddings to find conceptually similar blocks. But just embedding individual bullet points doesn't work well for outliners. A block that just says "needs refactoring" is useless on its own.

If you've seen my Logsqueak project, you'll recognise the indexing approach here. Every block is indexed along with its complete structural lineage-the page name, properties, and the full chain of parent blocks above it.

Because it captures this nested context, the search index knows that a vague bullet point nested under billing-service → Database Connection Pool is actually about your Postgres setup. Searching for "optimizing billing db" will pull that specific child block right to the top of the results.

Running it locally

Since a Logseq graph is essentially a private brain dump, I wanted this to run entirely locally. By default, the plugin connects to Ollama using the lightweight nomic-embed-text model. It's smart enough to only re-embed blocks that have changed, so it's relatively fast even without a GPU. (If you prefer, you can also point it at any OpenAI-compatible endpoint in the settings).

I run Fedora Workstation and prefer to keep my host system clean, so I run Ollama via Podman. It's incredibly straightforward to set up:

# Start the Ollama container, exposing the default port and persisting data

podman run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama docker.io/ollama/ollama

# Pull the lightweight embedding model

podman exec -it ollama ollama pull nomic-embed-textBecause we mapped port 11434, the Semantic Search plugin can talk to the container seamlessly at http://localhost:11434 right out of the box. No dependency issues, just a private embedding server ready to run in the background.

Usage

You can grab the plugin directly from the Logseq Marketplace. Once it's installed, hit Alt+K (or click the toolbar icon) to open the search modal. Try typing a natural language query-like "notes about debugging pipeline failures"-and it will surface the relevant blocks even if you didn't use the word "debugging."

The source code is up on GitHub if you want to poke around or contribute.

The post Searching Logseq by Concept, Not Keystrokes appeared first on PRINT HEAD.

10 Mar 2026 1:46pm GMT

Peter Czanik: New toy: Installing FreeBSD on the HP Z2 Mini

10 Mar 2026 12:13pm GMT

Fedora Magazine: Announcing Fedora Linux 44 Beta

On Tuesday, 10 March 2026, it is our pleasure to announce the availability of Fedora Linux 44 Beta! As with every beta release, this is your opportunity to contribute by testing out the upcoming Fedora Linux 44 Beta release. Testing the beta release is a vital way you can contribute to the Fedora Project. Your testing is invaluable feedback that helps us refine what the final F44 experience will be for all users.

We hope you enjoy this latest beta version of Fedora!

How to get the Fedora Linux 44 Beta release

You can download Fedora Linux 44 Beta, or our pre-release edition versions, from any of the following places:

- Fedora Workstation 44 Beta

- Fedora KDE Plasma Desktop 44 Beta

- Fedora Server 44 Beta

- Fedora IoT 44 Beta

- Fedora Cloud 44 Beta

The Fedora CoreOS "next" stream rebases to Fedora beta content on the same day as the beta release. To try out Fedora Linux 44-based CoreOS, try out the Fedora CoreOS "next" stream today.

You can also update an existing system to the beta using DNF system-upgrade.

The Fedora Linux 44 Beta release content may also be available for Fedora Spins and Labs.

Fedora Linux 44 Beta highlights

Like every Beta release, the Fedora Linux 44 Beta release is packed with changes. The following are highlights from the full set of changes for F44. They are ready for you to test drive in the Fedora Linux 44 Beta.

Installer and desktop Improvements

Goodbye Anaconda Created Default Network Profiles: This change impacts how Anaconda populates network device profiles. Only those devices configured during installation (by boot options, kickstart or interactively in UI) become part of the final system install. This behavior change addresses some long standing issues caused by populating network profiles for all network devices. These made it difficult to correctly reconfigure devices post-install.

Unified KDE Out of the Box Experience: This change introduces the post-install Plasma Setup application for all Fedora KDE variants. In the variants making use of this new setup application, the Anaconda configuration will be adjusted to disable redundant configuration stages that duplicate the functionality exposed in the setup application.

KDE Plasma Login Manager: This change introduced the Plasma Login Manager (PLM) for Fedora KDE variants instead of SDDM for the default login manager.

Reworked Games Lab: This change modernizes the Games Lab deliverable by leveraging the latest technologies. This offers a high quality gaming and game development experience. It includes a change from Xfce to KDE Plasma to take advantage of the latest and greatest Wayland stack for gaming.

Budgie 10.10: Budgie 10.10 is the latest release of Budgie Desktop. Budgie 10.10 migrates from X11 to Wayland. This ensures a viable long-term user experience for Fedora Budgie users and lays groundwork for the next major Budgie release.

LiveCD Improvements

Automatic DTB selection for aarch64 EFI systems: This change intends to make the aarch64 Fedora Live ISO images work out of the box on Windows on ARM (WoA) laptops. This will automatically select the right DTB at boot.

Modernize Live Media: This change modernizes the live media experience by switching to the "new" live environment setup scripts provided by livesys-scripts and leverage new functionality in dracut to enable support for automatically enabling persistent overlays when flashed to USB sticks.

System Enhancements

GNU Toolchain Update: The updates to the GNU Toolchain ensure Fedora stays current with the latest features, improvements, and bug and security fixes from the upstream gcc, glibc, binutils, and gdb projects. They guarantee a working system compiler, assembler, static and dynamic linker, core language runtimes, and debugger.

Reproducible Package Builds: Over the last few releases, we changed our build infrastructure to make package builds reproducible. This is enough to reach 90%. The remaining issues need to be fixed in individual packages. With this change, all package builds are expected to be reproducible in the F44 final release. Bugs will be filed against packages when an irreproducibility is detected. The goal is to have no fewer than 99% of package builds reproducible.

Packit as a dist-git CI: This change continues down the path of modernizing the Fedora CI experience by moving forward with the final phase of the plan to integrate Packit as the default CI for Fedora dist-git.

Remove Python Mock Usage: python-mock was deprecated with Fedora 34. However, it is still in use in many packages. We plan to go through the remaining usages and clean them up, with the goal of retiring python-mock from Fedora.

Adoption of new R Packaging Guidelines: This change introduces new rpm macros to help standardize and automate common R language packaging tasks resulting in a simplification of the rpm spec files.

Introduction of Nix Developer Tool: This change adds the nix package manager developer tool to Fedora.

Hardlink identical files in packages by default: With this change, all fedora packages will automatically hardlink files under /usr by default as a post install action. The mechanism introduced in this change is designed specifically to address reproducibility validation race conditions found in use by traditional hardlinking approaches.

Fedora Linux 44 Beta upgrades and removals

Golang 1.26: Fedora users will receive the most current and recent Go release. Being close to upstream allows us to avoid security issues and provide more updated features. Consequently, Fedora will provide a reliable development platform for the Go language and projects written in it.

MariaDB 11.8 as Distribution Default Version: The distribution default for MariaDB packaging will switch to 11.8. Multiple versions of the MariaDB packages will continue to be available. This change only impact which of the versioned packages presents itself as the unversioned "default"

IBus 1.5.34: Fedora users will benefit from better support of Wayland and Emoji features.

Django 6.x: Fedora Users can make use of the latest Django version; users who use Django add-ons that are not ready for 6.0 yet should be able to switch it out for python3-django5

TagLib 2: This change puts Fedora on the latest supported version, and it will benefit from improvements in future minor releases with a simple update.

Helm 4: Helm 4 has been released upstream with intentional backwards-incompatible changes relative to Helm 3. To ensure a smooth transition for Fedora, this Change introduces Helm 4 as the default helm package, while providing a parallel-installable helm3 package for users and tooling that still rely on Helm 3.

Ansible 13: Update from Ansible 11 and Ansible Core 2.18 to Ansible 13 and Ansible Core 2.20. This includes major robustness and security fixes to the templating engine which might break existing playbooks that had incorrect behavior. This was silently ignored in previous releases.

TeXLive 2025: With this change, we update to the latest version of TeXLive (2025). We also move to a modularized packaging system, which splits the "texlive" SPEC into a set of collection and scheme packages. This reflects the categorization that TeXLive upstream defines. Each collection package will package the immediate component dependencies as subpackages.

Drop QEMU 32-bit Host Builds: Fedora will stop building QEMU on i686 architecture. This change brings Fedora inline with the QEMU upstream project decision to deprecate support for 32-bit host builds. Upstream intends to start removing 32-bit host build support code in a future release and will assume 64-bit atomic ops in all builds.

Drop FUSE 2 libraries in Atomic Desktops: Remove FUSE 2 binaries and libraries from all Atomic Desktops

Drop compatibility for pkla polkit rules in Atomic Desktops: Remove support for deprecated pkla polkit rules from all Fedora Atomic Desktops

More information about Fedora Linux 44 Beta

Details and more information on the many great changes landing in Fedora Linux 44 are available on the Change Set page.

Editor's Notes

- Previously, it was noted that Fedora CoreOS "next" stream releases a week after the beta. This was a publishing error. The Fedora CoreOS "next" stream releases on the same day as the beta release. The article was edited to clarify this error.

10 Mar 2026 8:00am GMT

09 Mar 2026

Fedora People

Fedora People

Kushal Das: In the land of XML

09 Mar 2026 7:22am GMT

Miroslav Vadkerti: Silencing Alerts During OpenShift Cluster Upgrades with Prometheus and Alertmanager

09 Mar 2026 12:00am GMT

08 Mar 2026

Fedora People

Fedora People

Ben Cotton: You’d better start believing in supply chains because you’re in one (SCaLE 23x)

At SCaLE 23x, I debuted "You'd better start believing in supply chains because you're in one." This is my first talk that started as a silly joke, but it covers a serious and timely topic.

Abstract: "I'm not a supplier!" open source maintainers correctly say. When a large company comes in making unfunded demands, it drives volunteer maintainers away. But supply chain attacks are a reality and they don't just affect megacorps. As an open source maintainer, you have a supply chain, too.

Improving your security improves safety for everyone. But how can volunteer maintainers who aren't security experts do this work? This talk introduces easy practices and tools to address common software supply chain concerns. Attendees will also learn how to address supply chain and regulatory concerns from their downstreams.

Date: 8 March 2026

Location: Pasadena, CA, US

Resources

Looking for links to the tools I mentioned in the talk, perhaps because you're sitting in the audience right now?

- 2020 State of the Octoverse Report

- Best Practices Badge

- Cyber Resilience Act

- Dependabot

- Docker Scout

- Food, Drug, & Cosmetics Act § 524B

- GitHub Immutable Releases

- GUAC

- Kusari Inspector

- LFX Insights

- Minder

- npm audit

- OMB Memorandum M-26-05

- OpenSSF Scorecard

- OSPS Baseline

- OWASP Dependency-Check

- Trusted Publishers

- Zizmor

The post You'd better start believing in supply chains because you're in one (SCaLE 23x) appeared first on Duck Alignment Academy.

08 Mar 2026 7:53pm GMT

07 Mar 2026

Fedora People

Fedora People

Kevin Fenzi: misc fedora bits first week of march 2026

Here we are in the first week of March 2026 already. This was a pretty quiet week for me, partly due to the Fedora 44 Beta freeze and partly I think due to people traveling/being away. In any case it was welcome to me to have a chance to work on some planned work instead of day to day or fighting fires.

GPU machine

This week I finally got our gpu machine all setup, which has been a very long road. Last year we thought it would be very handy to have a machine that has desktop GPUs in it that we could use to test / build / explore things that could use those. We didn't want a server with fancy datacenter gpus, we wanted things that Fedora users might have. This of course is tricky, since that entails a desktop like machine in a datacenter.

After some looking around, we found the Dell Precision 7960 Rack, which is a rackmount machine, but sort of a desktop too.

We got a loaner to test things out with, and finally decided to buy it and use it. There have been so many little delays with this thing ( wrong network card, need a new one. Time of people involved to setup the testing. Drac license was wrong and I couldn't install it, and more).

But finally this week it's up. We will see how useful it becomes and what new exciting things it opens up.

Fedora 44 Beta is GO for release next tuesday

We had our Fedora 44 Beta go/nogo meeting on thursday and amazinly we were go for release on tuesday. The second beta candidate had no accepted blockers. I'm always a bit surprised when things go so smoothly, but I will take it!

Secure boot signing

I also made some more progress on my secure boot signing setup, but then i hit a blocker. I was able to sign grub and kernel for aarch64, but it doesn't actually boot. (I have my lenovo slim7x and also another aarch64 box that supports secure boot to test with). Hopefully we can get to the bottom of that soon so we can switch things on. I really hope we can have it running before Fedora 44 final freeze.

This also has been a long road.

Just missed it

I'm getting a solar system with batteries and home backup installed late this month, and I'm really looking forward to it.

Unfortunately, my electic coop just informed me that there is going to be a 4 hour power outage on monday for maint work. If it had only been next month, I could have just ignored it. Oh well, one more time for the generator! :)

comments? additions? reactions?

As always, comment on mastodon: https://fosstodon.org/@nirik/116189196834124254

07 Mar 2026 5:27pm GMT

Avi Alkalay: Ideal Laptop

Do you remember the most important characteristics you should look for in a good laptop? In the following order:

1⃣ A high-resolution, high-density display: 3K or 4K, far beyond HD or Full HD

2⃣ A battery that lasts all day

3⃣ Fast storage (SSD)

4⃣ Light, thin, and elegant

It's not the CPU.

It's not the CPU.

It's not AI.

It's not AI.

It's not having huge storage capacity.

It's not having huge storage capacity.

It's not a large physical size.

It's not a large physical size.

It's not having more than 8 GB of memory (memory is not storage).

It's not having more than 8 GB of memory (memory is not storage).

It's not having a stylus, tablet convertible, or having a detachable or articulated keyboard.

It's not having a stylus, tablet convertible, or having a detachable or articulated keyboard.

And it's definitely not having a numeric keypad on the side.

And it's definitely not having a numeric keypad on the side.

Until last week, the best and most affordable laptop on the market with these characteristics was the $1100 MacBook Air. But now Apple has launched the MacBook Neo, which delivers all these qualities - display, battery, storage, lightness, and elegance for 45% less: $600.

❝A laptop for me is just for browsing the internet, email, editing documents, messaging, watching movies, and relaxing with games like Solitaire or Roblox.❞

Congratulations, you're like 99.9% of humanity. The MacBook Neo delivers the best value for you.

In the Windows laptop universe, these truly important characteristics (display quality, lightness, etc.) are usually found only in the most expensive product lines. To justify the high price, their marketing shifts the focus to things that are largely irrelevant: unnecessarily powerful CPUs, unnecessarily large storage, unnecessarily large memory, tablet modes, styluses, and so on.

All unnecessary for 99.9% of humanity.

And even in those expensive lines, the battery rarely lasts more than two hours, let alone all day. The reason: inefficient CPU.

Don't be misled when choosing your next laptop. Pay attention to the characteristics that really matter: hires display, battery duration, fast storage, lightness, and elegance. General rule is to avoid laptops that use Intel CPUs.

This also applies to the laptops that companies give to their employees.

Also in my Instagram, Facebook and LinkedIn.

07 Mar 2026 8:15am GMT

Avi Alkalay: Laptop ideal

Lembra quais são as características mais importantes que você deve procurar num bom laptop? 1⃣ tela de alta resolução e densidade, 3K ou 4K, bem mais que HD ou full HD; 2⃣ bateria que dura o dia todo; 3⃣ armazenamento rápido (SSD); 4⃣ leve, fino e elegante.

Não é CPU.

Não é CPU.  Não é IA.

Não é IA.  Não é armazenamento grande.

Não é armazenamento grande.  Não é ter tamanho físico grande.

Não é ter tamanho físico grande.  Não é ter mais do que 8GB de memória (memória não é armazenamento).

Não é ter mais do que 8GB de memória (memória não é armazenamento).  Não é ter caneta, virar tablet, teclado removível ou articulado.

Não é ter caneta, virar tablet, teclado removível ou articulado.  E definitivamente não é ter teclado numérico lateral.

E definitivamente não é ter teclado numérico lateral.

Até semana passada, o melhor e mais barato laptop do mercado com essas características era o MacBook Air de $1100. Mas agora a Apple lançou o MacBook Neo que entrega todas essas características de tela, bateria, armazenamento, leveza e elegância, 45% mais barato: $600.

❝Laptop prá mim é só prá navegar na internet, e-mail, editar documentos, mandar mensagem, assistir filmes, me distrair jogando paciência e Roblox❞. Parabéns, você é como 99,9% da humanidade. O MacBook Neo entrega o melhor custo-benefício para você.

No universo dos laptops Windows, essas características importantes (tela, leveza etc), só se encontram nas linhas mais caras dos fabricantes. E para justificar o alto preço, seu marketing procura mudar o foco para coisas completamente irrelevantes, como CPU desnecessariamente poderosa, armazenamento desnecessariamente alto, memória desnecessariamente grande, virar tablet, ter caneta etc. Desnecessário para 99,9% da humanidade. E mesmo assim, nem nessas linhas mais caras a bateria dura mais do que 2 horas (motivo: CPU ineficiente), quanto menos o dia todo.

Não seja ludibriado ao escolher seu próximo laptop. Preste atenção nas características que realmente importam: tela, bateria, armazenamento rápido, leveza e elegância. A regra geral é evitar laptops com CPUs Intel.

Isso vale também para laptops que empresas dão a seus funcionários.

Também no meu Instagram, Facebook e LinkedIn.

07 Mar 2026 7:56am GMT

06 Mar 2026

Fedora People

Fedora People

Fedora Community Blog: Final Reminder: Flock 2026 Financial Assistance Applications Close Sunday, March 8th

Do you want to join us for our annual contributor conference? We want to see you there! However, we know that traveling to a global event is a big trip. It costs real money. To help out, the Flock Organizing Team offers Flock 2026 financial assistance. We want to make sure money does not stop our active contributors from attending.

This is your final reminder. You must submit your form by Sunday, March 8th, 2026. The organizing team starts looking at the data on Monday morning. Because of this fast timeline, we cannot accept any late forms. Sunday is a hard stop.

What does this funding actually cover? We can help you pay for your travel. This includes your airfare or train tickets. We can also help cover your hotel room at the main event venue. We have a limited budget. Because of this, we cannot fully fund every person who applies. Your peers on the organizing team review all the forms. They look at your community impact to make these tough choices.

Note for Flock 2026 speakers

Are you giving a talk this year? We are excited to hear from you! But please remember one important rule. Being an accepted speaker does not give you guaranteed funding. You still need to ask for help. All speakers must fill out the Flock 2026 financial assistance form if they need travel support.

Apply for Flock 2026 financial assistance

Applying is easy. Just follow these steps:

- Open the Google Form application.

- Fill in your travel details and your estimated costs.

- Explain your recent work and your impact in the Fedora community.

- Submit the form before the end of the day on Sunday, March 8th.

We want to bring as many builders and contributors together as possible. Please do not wait until the last minute. If you need support to join us, fill out the application today!

The post Final Reminder: Flock 2026 Financial Assistance Applications Close Sunday, March 8th appeared first on Fedora Community Blog.

06 Mar 2026 10:15am GMT

Fedora Community Blog: Community Update – Week 10 2026

This is a report created by CLE Team, which is a team containing community members working in various Fedora groups for example Infrastructure, Release Engineering, Quality etc. This team is also moving forward some initiatives inside Fedora project.

Week: 02 - 06 March 2026

Fedora Infrastructure

This team is taking care of day to day business regarding Fedora Infrastructure.

It's responsible for services running in Fedora infrastructure.

Ticket tracker

- Migrated remaining pagure.io repositories, there is one remaining, but needs to have private issues implemented

- Provide DNS domain name for konflux (ticket)

- Meeting with the IPA-tuura team to move forward with the Ipsilon replacement project

CentOS Infra including CentOS CI

This team is taking care of day to day business regarding CentOS Infrastructure and CentOS Stream Infrastructure.

It's responsible for services running in CentOS Infratrusture and CentOS Stream.

CentOS ticket tracker

CentOS Stream ticket tracker

- investigate jenkins repo gpg key change

- zabbix agent fails to load on rhel 10.1 due to selinux policy mismatch

- Podman/crun issue on ansible ARA host

- Enable side tag feature

- Add AIE to sigs.centos.org

- Enable draft builds in CBS

- [spike] verify how to prevent self-registration on mailman3 instance (outside of allowing FAS/ACO accounts)

- Update pungi for CentOS Stream

Release Engineering

This team is taking care of day to day business regarding Fedora releases.

It's responsible for releases, retirement process of packages and package builds.

Ticket tracker

- Still in Beta Freeze, we have had a couple of release candidate composes for Fedora 44 Beta.

- GO/NO-GO call for the Beta Release is tentatively scheduled for Thursday, March 5th.

RISC-V

This is the summary of the work done regarding the RISC-V architecture in Fedora.

- Continue to comb through the list of Fedora packages that need work - submit changes to Fedora / upstream, review patches from others, and submit builds as needed.

- Build/test the RISC-V unified kernel.

- Figured out logistics for 24-h remote access to SpacemiT 'K3' hardware (based on RVA230

- Discussed with the RISC-V SIG and Fedora docs about migrating the Fedora RISC-V docs from the wiki to forge.

- Figure out the prerequisites for F44 builds - toolchain dependencies are being sorted out.

AI

This is the summary of the work done regarding AI in Fedora.

- Aurelien Bompard Worked on the AI-powered This Week in Fedora.

- Claude helped Gordon Messmer develop an extension to glibc's malloc API to solve a common problem with memory inflation, and produced some illustrations of the problem and solution. The write-up will be posted shortly. Draft at: https://codeberg.org/gordonmessmer/dev-blog/src/branch/main/memory-efficiency-with-arena-allocators.md

- Quality Team workflow for AI code review in Forgejo - easily reused if you're interested! https://forge.fedoraproject.org/quality/workflows/src/branch/main/.forgejo/workflows/ai-review.yml

QE

This team is taking care of quality of Fedora. Maintaining CI, organizing test days

and keeping an eye on overall quality of Fedora releases.

- Fedora 44 RCs are now available and under heavy testing. The Go/NoGo is scheduled in a few days. Lots of blocker (and not blocker) bugs were discovered, discussed, voted on and resolved.

- Kernel 6.19 test days are complete and Podman 5.8 test days are under way.

- A new version of BlockerBugs bot was implemented and deployed to staging, which should allow us to migrate blocker voting repository from Pagure to Forge (ticket).

- Our cloud automation now reports results to the production wiki for each new compose.

- The refactoring of Fedora Easy Karma was merged to the main branch. All places with links were also updated wrt the recent transition to Forge, and the migration is now done for this repo.

- Forge QA repos now has a reusable workflow for an AI review.

- More bugs hitting OpenQA automated testing were resolved, some some particular ones are very hard to debug, e.g. an ibus hang or an xdg-desktop-portal crash.

Forgejo

This team is working on introduction of https://forge.fedoraproject.org to Fedora

and migration of repositories from pagure.io.

- [Forgejo] New Organization and Teams Request: Fedora KDE [Followup]

- [Forgejo] Participated in the Forge review, planning and retrospective meet with Rodney, Nils, Ryan and David [Board]

- [Forgejo] New organisation for Fedora Code of Conduct committee + migration [Followup] [Namespace] [Followup]

- [Forgejo] New repo for Security SIG [Followup] [Namespace] [Followup] [Followup]

- [Forgejo] New Organization and Teams Request: Fedora Btrfs [Followup] [Namespace]

- [Docs] Will be migrating Release Notes imminently + branching for F44, contributions welcome once the repo appears on Forgejo

- Forgejo runners added for orgs mindshare and apps

- Private Issues

- Unit tests for code ⇔ DB boundary (Issue & PrivateIssue: done, related types: ongoing)

- Verify, debug and fix DB migration

UX

This team is working on improving User experience. Providing artwork, user experience,

usability, and general design services to the Fedora project

- Updated all references to Fedora Design ticket tracker to point to Forgejo [ticket], migration of tickets still wip, but significant progress made.

If you have any questions or feedback, please respond to this report or contact us on #admin:fedoraproject.org channel on matrix.

The post Community Update - Week 10 2026 appeared first on Fedora Community Blog.

06 Mar 2026 10:00am GMT

Miroslav Vadkerti: How a Single Regex Stalled 30 Testing Farm Jobs for Hours

06 Mar 2026 12:00am GMT

05 Mar 2026

Fedora People

Fedora People

Christof Damian: Friday Links 26-08

05 Mar 2026 11:00pm GMT